Quelle que soit technologie sur laquelle elle s’appuie et quelle que soit la forme qu’elle prend, la visualisation des données - ou “dataviz” pour les intimes - a pris une ampleur sans précédent avec l’explosion du Big Data. Elle transforme durablement la place de la donnée en entreprise qui n’est plus une denrée rare, réservée à une élite ou à des experts qui soient les seuls à maîtriser son usage et sa diffusion. Grâce à la “dataviz”, la donnée est enfin libre ! Elle devient accessible et compréhensible par tous et à tout moment avec pour ambition de fluidifier le processus décisionnel.

De quand date la data visualisation ?

Malgré l’explosion des infographies ces dernières années, ce serait une erreur de penser que la visualisation des données est née avec le Big Data. L’être humain a rapidement pris conscience des limites de son cerveau et de son incapacité à traiter de grands volumes de données pour en extraire facilement des informations utiles. Pour contourner cette contrainte, la représentation visuelle est apparue comme une option permettant de rendre compréhensible ce qui ne l’était pas sous une autre forme et a été utilisée très tôt, bien avant l’apparition de l’informatique ou l’avènement du Big Data. N’est-ce pas Confucius au Ve siècle avant JC qui a dit « une image vaut mille mots » ?

Dans son livre « The Book Of Tree : Vizualising Branches Of Knowledges » Manuel Lima, célèbre chercheur et designer de l’information, affirme avoir daté les origines de la dataviz au Moyen-Age, soit plus de 900 ans en arrière... Il explique ainsi que les premières visualisations de données sont inspirées de la nature et reposent sur le modèle de l’arbre. Ainsi, un des premiers exemples marquant de Data Visualisation remonte au XIème siècle avec une illustration de la Bible qui représente la généalogie de Jésus de Nazareth à partir de Jessé, père du roi David. L’arbre de Jessé synthétise l’ensemble des informations relatives aux ascendants du Christ qui sont clairsemées au fil des pages. Cette analogie organique rend les données lisibles et permet d’accéder intuitivement à tout ou partie de l’information.

L’arbre de Jessé (1086), Codex Vyssegradensis, (Prague Metropolitan Chapter Library)

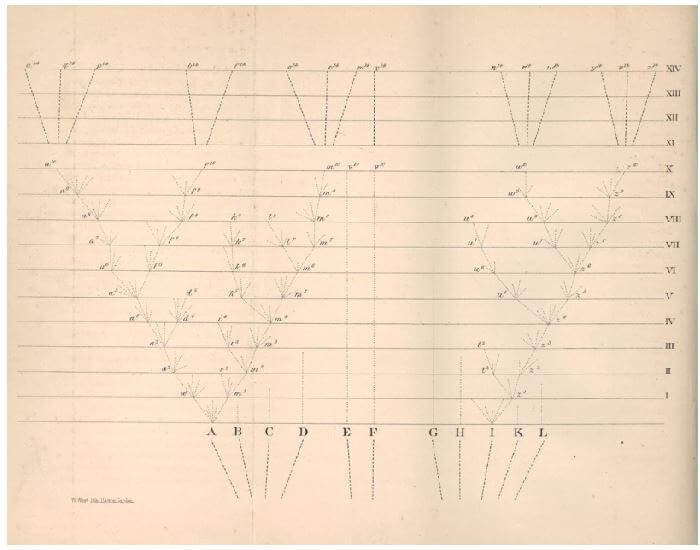

L’arbre occupe donc une place particulière dans le monde de la dataviz et il sera utilisé par beaucoup de scientifiques, de philosophes, de chercheurs, d’écrivains au fil des époques. Le philosophe catalan Raymond Lulle au XIVème siècle s’en est servi par exemple pour représenter les diverses disciplines en sciences. Plus tard, à la fin du XIXème siècle, un certain Charles Darwin l’utilisera pour illustrer sa théorie de l’évolution avec le « Tree of life »). Aujourd’hui encore, les arbres sont utilisés sous des formes plus abstraites pour structurer ou hiérarchiser des idées et des concepts.

L’arbre de Jessé (1086), Codex Vyssegradensis, (Prague Metropolitan Chapter Library)

Tree of Life (1859), Charles Darwin (On the Origin of Species)

Année après année, par un long processus de maturation, la visualisation des données s’est enrichie d’autres formes graphiques : des histogrammes, des courbes, des diagrammes… Ce sont souvent des initiatives isolées qui ont permis à la dataviz de se développer et des noms ont ainsi marqué l’histoire :

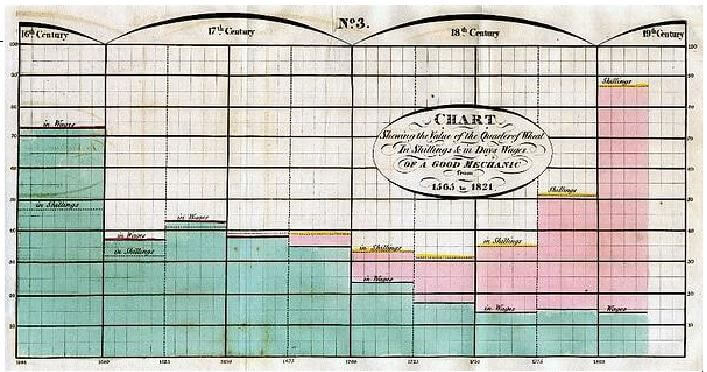

William Playfair (1759-1823), ingénieur et économiste écossais a été l'un des pionniers de la représentation graphique de données statistiques et c’est à lui que l’on doit le premier histogramme qui fut utilisé en 1786 dans son livre « Commercial and Political Atlas » pour représenter les importations et les exportations de l'Écosse pour l'année 1781 avec 17 pays. Grâce à lui, sont également apparus à la fin du XVIIIe siècle les premières séries temporelles et les premiers diagrammes circulaires (que nous appelons communément « camemberts » en France ou « pie chart » de l’autre côté de la Manche). Toutes ses inventions sont encore utilisées aujourd’hui, plus de 200 ans après. Qui peut encore prétendre que la dataviz est née avec l’informatique ?

Représentation graphique de William Playfair

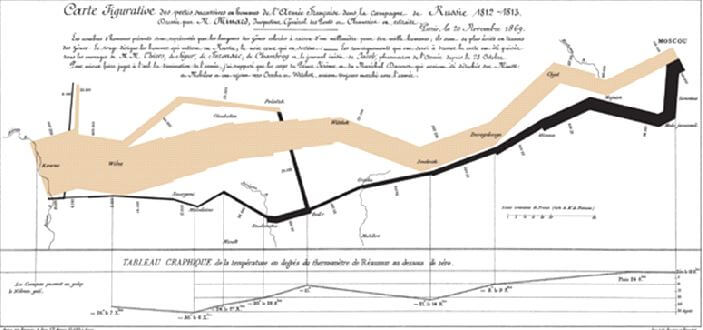

Charles Joseph Minard (1781-1870) fut un autre pionnier dans l’utilisation des graphiques appliqués au génie civil et aux statistiques. Cet ingénieur français est devenu célèbre avec sa carte figurative des pertes successives en hommes de l’Armée française dans la campagne de Russie en 1812-1813, une représentation graphique publiée en 1869 relative à la désastreuse campagne de Russie entreprise par Napoléon. Ce graphique présente plusieurs variables au sein d’une illustration en deux dimensions : localisation et itinéraire de l’armée, pertes humaines et variations de la température de l’air. On découvre ici toute la puissance de la data visualisation : il ne s’agit pas seulement de chiffres ou de formes graphiques, c’est bien plus que cela. Étienne-Jules Marey, médecin-physiologiste français et inventeur de la chronophotographie parle de ce graphique en insistant sur sa « brutale éloquence » qui « semble défier la plume de l’historien ». C’est bien de cela qu’il s’agit : la dataviz a non seulement pour ambition de simplifier, de synthétiser mais aussi de donner de l’impact, de raconter une histoire autour des chiffres.

Carte figurative des pertes successives en hommes de l’Armée française dans la campagne de Russie en 1812-1813 - Charles Joseph Minard (1869)

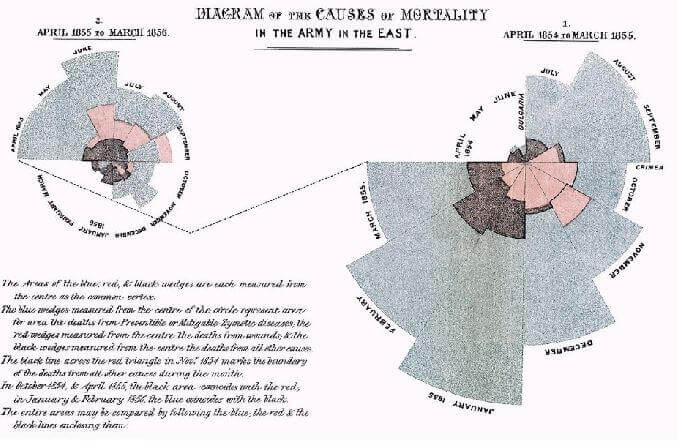

Florence Nightingale (1820-1910) est une infirmière britannique qui fut pionnière dans l'utilisation des statistiques dans le domaine de la santé. Après la Guerre de Crimée, elle se met à utiliser une version améliorée des diagrammes de Playfair (qu’elle nomme « coxcomb », que l’on peut traduire par « crête de coq »), afin d'illustrer les causes de mortalité des patients de l'hôpital militaire qu'elle gère. Son support graphique, daté de 1858, lui a ainsi permis de mettre en évidence que les épidémies avaient été bien plus dévastatrices sur les effectifs que les blessures subies au combat. La dataviz avait ici pour but d’illustrer des corrélations mais aussi de convaincre en orientant la conclusion que l’on retire de ces données.

Diagramme des causes de mortalité au sein de l'armée en Orient par Florence Nightingale

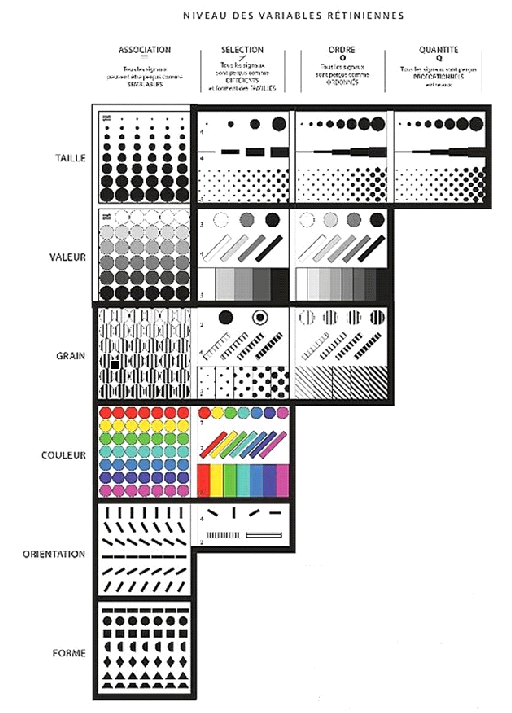

De simple illustration statique pour faire comprendre, la visualisation des données est progressivement devenue un moyen puissant d’expliquer et de convaincre. Au XXème siècle, elle a atteint sa maturité et est devenue un langage à part entière avec ses codes, ses règles, ses nuances et sa grammaire permettant ainsi d’en faciliter son utilisation et de la rendre universelle. Jacques Bertin (1918-2010) en fut un des principaux artisans au travers de son livre « Sémiologie graphique » publié en 1967 qui vise à jeter les bases de la pensée cartographique contemporaine.

Sémiologie Graphique (1973), Jacques Bertin

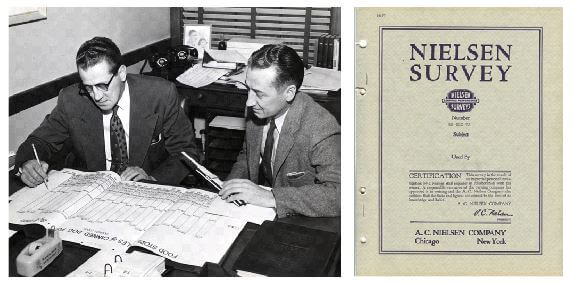

Après la seconde guerre mondiale, la période d’expansion économique a conduit la plupart des sociétés à utiliser de plus en plus de données et la data visualisation a fait ses premiers pas dans le monde de l’entreprise. Le marketing et les instituts d’études ont été très vite friands de représentations graphiques pour illustrer des concepts ou plus simplement suivre les performances des marchés et des marques. Par exemple, Nielsen a lancé un panel pour suivre les ventes de Produits de Grande Consommation aux Etats Unis dans les années 30 et exploité très rapidement la dataviz. Les consultants Nielsen présentaient ainsi les données à leurs clients à l’aide de livres grands formats (cf. photo) sur lesquels étaient dessinées des représentations graphiques. Tous les mois, les graphiques étaient mis à jour et complétés avec les nouvelles données de vente et de part de marché.

Les premiers pas de la dataviz dans l’institut d’études marketing Nielsen

Avec le développement de l’informatique, de nouvelles opportunités de développement se sont offertes à la dataviz. Jacques Bertin, toujours lui, a introduit la notion de « mobilité » de l’image et de « graphique dynamique ». Il expliqua ainsi : « On ne dessine plus un graphique une fois pour toutes. On le construit et on le reconstruit. On le manipule jusqu’au moment où toutes les relations qu’il recèle ont été perçues. » Les logiciels de traitement de données ont rendu cela possible et ont donc permis de franchir une nouvelle étape. A ce titre, Jacques Bertin fut le trait d’union avec les chercheurs contemporains de la Data Visualisation que sont Edward Rolf Tufte, Ben Shneiderman ou Stephen Few. Ces derniers ont écrit des ouvrages de référence (« The Visual Display of Quantitative Information » par E. Tufte, « Information Dashboard Design » par S. Few, « Readings in Information Visualization: Using Vision to Think » par B. Shneiderman) imaginant de nouvelles représentations graphiques, édictant des règles du jeu pour différencier la bonne de la mauvaise data visualisation.

On le voit bien, la dataviz ne date pas d’hier. Elle a aujourd’hui envahi notre champ visuel car les données disponibles ont-elles-mêmes explosé mais la visualisation des données a toujours existé ou presque. Son utilité a été reconnue bien avant l’arrivée du Big Data mais la technologie lui a permis de s’améliorer pour ne plus être seulement un moyen d’expression mais de devenir un moyen de conviction. Son rôle est multiple à présent dans nos sociétés.

A quoi peut-elle bien servir aujourd’hui et pourquoi est-elle si présente ?

La dataviz est désormais partout et cela concerne aussi bien la sphère publique que privée. Elle a envahi notre champ visuel : aucun article de presse ne semble pouvoir paraître sans être accompagné d’une infographie, aucune application mobile ne semble pouvoir exister sans y faire appel… Elle a envahi nos smartphones, nos tablettes, nos ordinateurs, nos téléviseurs… Cette invasion n’est que la conséquence de l’explosion des données : sans le Big Data, elle n’aurait certainement pas pris la place qu’elle a aujourd’hui. Néanmoins, il faut aussi lui reconnaître de nombreux bénéfices pour ses utilisateurs et cela en explique le succès phénoménal.

1. Gagner du temps

Tout va plus vite et la dataviz participe à ce mouvement en accélérant l’assimilation des données et la prise de décision. Le monde des études de marché auquel j’appartiens est de plus en plus avide. Au cours des 20 dernières années, nous avons été amenés à traiter pour nos clients de plus en plus de données et de plus en plus vite. Nielsen reçoit quotidiennement en France les données de vente de centaines de milliers de produits en provenance de plus de 20 000 magasins. Nos clients – qu’ils soient fabricants ou distributeurs – ont rencontré les mêmes défis : digérer de plus en plus d’informations, de plus en plus vite dans un environnement de plus en plus concurrentiel et avec des ressources à la baisse. Cette équation s’est avérée très rapidement inextricable avec les outils du XXème siècle. Qui n’a pas passé des heures interminables à analyser des données à partir de tableaux Excel au nombre infini de lignes… ? La dataviz s’est imposée à tous pour faire partie du quotidien de chacun et a mis un terme à ces tâches fastidieuses et chronophages en donnant accès aux données sous une forme visuelle (courbes, histogrammes, cartographies…). De nombreuses sociétés se sont spécialisées dans ce domaine et les géants de l’internet en ont très vite compris l’enjeu et ont investi massivement : Google a racheté la plateforme Looker en juin 2019 pour 2,6 milliards de dollars et le roi du CRM - Salesforce - a annoncé en août 2019 avoir conclu le rachat de l'entreprise Tableau Software pour 15,7 milliards de dollars.

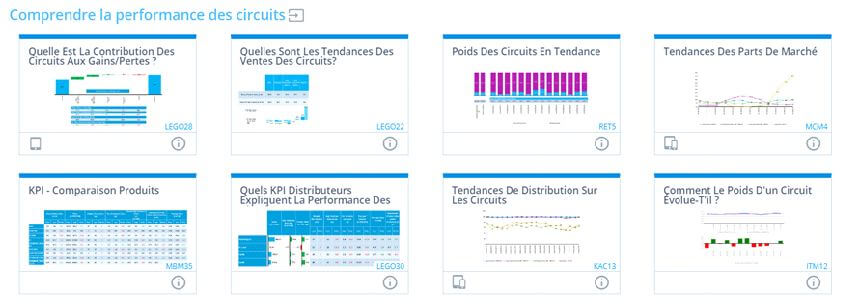

A une moindre échelle dans le domaine des études marketing, nous assistons aussi à une course à la data visualisation. Les clients des instituts d’études que sont les industriels ou les distributeurs doivent faire preuve d’agilité dans leur processus décisionnel et c’est de la responsabilité de leurs prestataires études de faire en sorte que la donnée qu’ils mettent à leur disposition est « pré-digérée », prête à l’emploi, qu’elle soit dans une forme visuelle qui apporte des réponses immédiates. La technologie - une fois de plus - a joué un rôle prépondérant pour simplifier les accès à la donnée et la rendre la plus fluide possible au travers d’interface intuitive et collaborative. Si nous prenons l’exemple de Nielsen, l’époque des graphiques dessinés à la main appartient à la préhistoire. Aujourd’hui, les utilisateurs des panels accèdent aux données via une interface web personnalisée très simple mais néanmoins très complète pour couvrir toutes les demandes au sein de l’entreprise : marketing, commercial, comité de direction, force de vente.... Cette interface s’appelle « Nielsen Connect Express ».

L’ interface propose des mises en forme pré-formatées et élaborées à partir des questions les plus fréquentes posées par les clients. A chaque question, une réponse graphique correspond. Ces représentations visuelles ne sont pas figées afin de répondre pleinement au précepte de « mobilité » de l’image défendu par Jacques Bertin. L’utilisateur conserve la mise en forme mais peut changer les paramètres tels que la période, le circuit de distribution, ou le produit analysé.

Nielsen Connect Express – exemples de mises en forme pré-formatées répondant à des questions précises

La dataviz est dynamique pour permettre la manipulation des données sans en conserver le fardeau de la mise en forme. L’utilisateur navigue au travers de ces vignettes (appelées iSights) et peut les sauvegarder, les exporter vers d’autres logiciels (Excel, PDF, Power Point) ou les automatiser. L’utilisateur peut se concentrer sur l’essentiel : l’analyse et la prise de décision.

2. Mieux communiquer

Communiquer, c’est transmettre un message avec pour objectif d’informer ou de convaincre son interlocuteur. La data visualisation est devenue le moyen efficace de traduire un déluge de données en des informations digestes et compréhensibles. A ce titre, c’est un outil de communication puissant car synthétique et rapide à consommer : on peut résumer en un graphique ce qu’il faudrait expliquer dans des dizaines de page de texte. C’est une évidence mais une infographie est tellement plus simple à lire et à retenir qu’un long texte sans couleur, sans image… Au fil du temps, par nécessité ou par paresse, nous lisons moins et devenons de plus en plus dépendants des images sous toutes les formes (photos, vidéos, infographies…). Il semble impossible de revenir en arrière et le comportement des nouvelles générations laisse penser que l’écrit aura de plus en plus de mal à s’imposer face à l’image. Pour ne pas prendre le risque de tronquer l’information, l’écrit aura toujours sa place mais l’accroche devra se faire par l’image et la dataviz a ainsi toute sa place. Communiquer suppose aujourd’hui d’aller vite, de faire un focus sur l’essentiel, de trouver les quelques chiffres qui marquent. Qui y a-t-il de mieux qu’une infographie pour passer un message et pour marquer les esprits ?

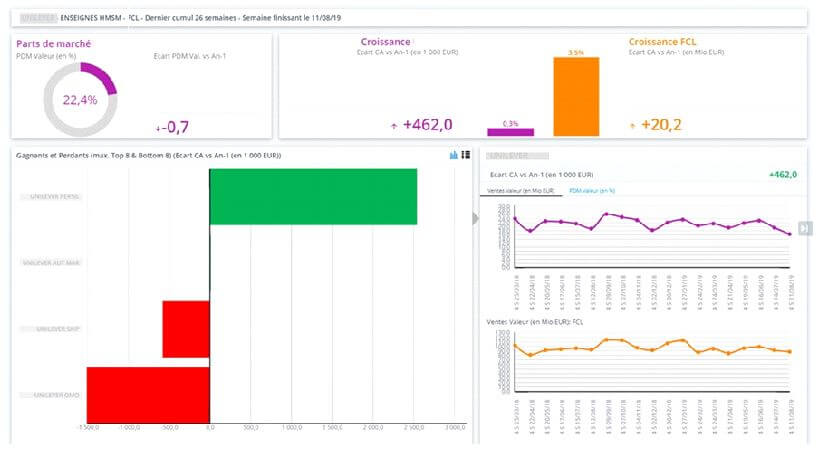

La dataviz permet le regroupement de données disparates sur un seul écran, grâce à différents graphiques pertinents liés les uns aux autres. Ces indicateurs peuvent être rassemblés sur des dashboards fournissant une information facilement lisible et permettant une fois de plus la compréhension des phénomènes et donc la prise de décision.

Nielsen Connect Express – exemple de dashboard agrégeant plusieurs indicateurs sur une même page

3. Offrir plus de transparence

Un des apports les plus importants de la dataviz est donc la démocratisation des données : elle permet à un plus grand nombre de personnes d’accéder et de manipuler les données sans forcément posséder une quelconque expertise technique. Détenir l’information, c’est aussi détenir le pouvoir. Enjeu majeur au sein de l’entreprise, les données ont été pendant très longtemps jalousement gardées par certaines personnes ou certains départements dans l’entreprise. En rendant la donnée à présent accessible à tous et compréhensible par tous, la data visualisation fait tomber les frontières, aplatit les hiérarchies, remet en question les organisations, transforme le processus décisionnel et répond à une soif de transparence devenue omniprésente aujourd’hui.

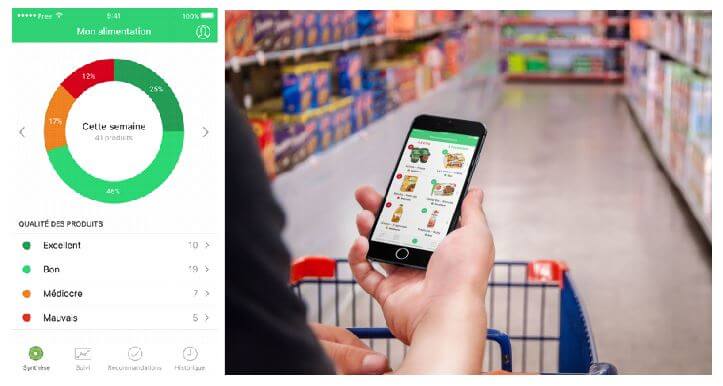

Prenons un exemple de notre quotidien pour illustrer cet apport : les applications mobiles qui décryptent l’alimentation. Bien que la qualité des produits alimentaires en France n’ait jamais été aussi bonne et les contrôles sanitaires jamais aussi nombreux, un climat de défiance envers les produits industriels s’est installé en France. Des applications ont décidé d’y apporter une réponse en « brassant » toutes les listes d’ingrédients pour traduire cela en notation et en code couleur pour chacun des produits en fonction de sa dangerosité potentielle pour notre organisme. Quels sont les produits dangereux pour ma santé ou celle de ma famille ? Quels sont les aliments trop sucrés, trop salés, trop gras… ? Le consommateur moyen ne bénéficiant pas de connaissances nutritionnelles suffisantes ou ne sachant pas décoder les listes d’ingrédients, est incapable de répondre à ces questions sans l’aide de nouvelles applications telles que « Yuka » ou « Y'A Quoi Dedans ». Dans ces applications, la dataviz joue un rôle important en simplifiant l’information pour la rendre facile à lire et à comprendre par l’ensemble des consommateurs. Ainsi, Yuka traduit une liste d’ingrédients longue et complexes en une note sur 100 et la représente sous forme d’un code couleur : vert foncé pour excellent, vert clair pour bon, orange pour médiocre et rouge pour mauvais. Chaque consommateur peut ainsi décomposer son alimentation en fonction de ces couleurs et décider de modifier le choix des produits qu’il met dans son caddie.

La visualisation des données dans l’application Yuka

La transformation digitale des entreprises conduit à numériser tous les processus pour gagner en efficacité. Jamais autant de données n’avaient été produites et analysées en entreprise. Il est indéniable que le Big Data sans l’apport de la data visualisation perd de son impact. C’est pourquoi les outils de visualisation sont devenus omniprésents quel que soit le département de l’entreprise pour informer ou alerter les collaborateurs. Le reporting a toujours existé mais il entre dans une nouvelle dimension en faisant appel à plus de données avec une mise à jour plus fréquente, voire en temps réel et avec un travail consenti sur la visualisation qui est très important. C’est le prix à payer pour que l’information soit comprise, retenue et utilisée.

4. Se divertir et créer des émotions

La dataviz est en perpétuel mouvement et requiert des esprits créatifs. Quand le premier graphique est apparu, il était purement révolutionnaire et s’est distingué très vite des tableaux de chiffres. Face à l’explosion des diverses formes de représentations visuelles, la data visualisation doit sans cesse se renouveler pour que de nouvelles formes graphiques puissent se distinguer des autres, mieux capter l’attention de leurs utilisateurs, s’imprimer sur nos rétines. Ainsi, on ne peut nier qu’elle fait appel à certaines formes d’esthétisme et qu’à ce titre la frontière est parfois mince avec une discipline artistique. La dataviz peut donc aussi servir à se divertir et va de ce fait au-delà de ce qui était sa mission initiale : certains artistes se sont mis à l’utiliser en y voyant un moyen de créer des œuvres.

Par exemple, l’abstraction géométrique s’apparente d’une certaine façon à la data visualisation. Les œuvres de François Morrelet (1926-2016) sont particulièrement intéressantes de ce point de vue car elles sont exécutées d’après un système : chaque représentation visuelle est définie par un principe établi par avance. Il utilise des toiles carrées et des chiffres aléatoires qui définissent en fonction du système la position des éléments, leur couleur, leur matériau (laque, néon, peinture acrylique…), l’angle d’inclinaison de la toile, le nombre d’angles droits… Chacune des décisions est donc objective, la seule décision subjective étant de définir la règle du système. On peut ainsi réaliser une infinité d’œuvres. C’est une forme de data visualisation dont le seul but est purement artistique. Les formes créées correspondent bien à des données mais ne répondent à aucune analyse rationnelle.

Lunatique neonly n°1, Musée des beaux-arts de Rennes. Dans cette œuvre, les coordonnées permettant de tracées les courbes sont fournies par les chiffres aléatoires d’un annuaire de téléphone

On peut aussi parler du travail de Kirell Benzi qui se définit comme un « data artist ». Il décrit ainsi son approche : « alliant analyse de données et visualisation de réseaux, j’interpelle le spectateur en montrant que les algorithmes, au-delà de leur nécessité scientifique, peuvent être générateurs d’émotions. L’art semble s’être caché où on ne l’attendait pas ! ». Il créé ainsi des œuvres à partir de données : c’est donc bien une forme de data visualisation artistique. Par exemple, on peut citer sa réalisation de plusieurs dataviz sur l’univers de Star Wars. Il a récolté et analysé une importante masse de données produites par des fans de la saga et a créé des cartes, qui permettent de mettre au jour des interconnexions insoupçonnées entre plus de 20 000 personnages, sur les 36 000 années que recouvre l’œuvre de Science-Fiction !

The Dark Side and the Light, Kirell Benzi

Et demain ?

L’explosion de la donnée ne va pas s’arrêter et l’arrivée de la 5G va donner accès à toujours plus de données toujours plus vite qu’il faudra traiter et visualiser… Si la donnée explose et l’informatique progresse, notre cerveau va – quant à lui - conserver ses limites… La dataviz a donc encore de beaux jours devant elle mais parviendra-t-elle à relever continuellement ce défi ?

Elle est appelée à être de plus en plus exploratoire et de plus en plus interactive pour permettre à l’utilisateur de « jouer » avec la donnée. On commence ainsi à parler d’analytique visuelle comme une façon nouvelle d’analyser la donnée. Les statisticiens font place dans les entreprises aux data scientists dont la mission est de faire parler la donnée en s’appuyant sur les algorithmes et des outils puissants de visualisation. Le risque de recréer des experts de la donnée est proche et la dataviz ne doit pas se renier. Les utilisateurs de la donnée en bout de chaîne souhaiteront toujours que l’interaction avec l’information soit simple et intuitive. C'est l'une des principales raisons qui poussent aujourd'hui les technologies d’analyse à développer des outils "naturels" comme le langage ou la gestuelle. Explorer la donnée, oui, mais sans saisir une seule ligne de code, sans utiliser de langage informatique, sans taper de requêtes, sans même utiliser son clavier... Simplement en utilisant sa voix et en exprimant son besoin en langage naturel ou au travers de gestes. Dans son dernier roman, Transparence, Marc Dugain imagine le monde en 2060 et décrit un univers où l’écrit aurait progressivement disparu, où le langage naturel se serait imposé et serait sur le point d’être remplacé par la transmission mentale : plus besoin d’interface ou de représentation visuelle pour communiquer un message, une idée. A l’aide d’implants, la machine peut communiquer directement avec l’homme en imprimant des images dans son cerveau sans aucune représentation visuelle... Est-ce de la pure science-fiction ou l’avenir ? La technologie étant indissociable de la data visualisation, on peut imaginer que les 40 années qui nous séparent du monde imaginé par Marc Dugain vont donner lieu à des nouvelles façons de visualiser la donnée toujours plus créatives et disruptives pour peut-être un jour arriver à cet extrême. Avant cela, nous passerons probablement par des étapes intermédiaires : dataviz en 3D, réalité augmentée…

La question sous-jacente est l’éloignement qui ne cesse de grandir avec la donnée à l’état brut. En faisant appel à des algorithmes de plus en plus sophistiqué pour retravailler la donnée et la rendre intelligible et compréhensible, ne prend-t-on pas le risque de ne voir qu’une partie de l’information, de simplifier à l’extrême en perdant les nuances ? La visualisation des données renvoie aux limites de notre cerveau et à cette quête sans fin d’une intelligence artificielle plus rapide, plus puissante que celle de l’être humain : l’IA sera demain le moteur de la dataviz mais saura-t-elle garder un esprit critique pour éviter de confondre simplifier et caricaturer ?